Качество Hitman сравнили на DirectX 11 и DirectX 12 в новом видео

13 марта 2016 в 15:55

13 марта 2016 в 15:55

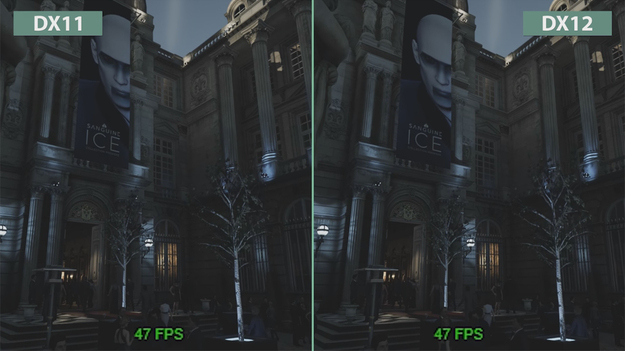

Перезагрузка Hitman стала одной из первых игр, которые поддерживают DirectX 12 с момента релиза. Поэтому для любителей графики грех было не сделать наглядное сравнение визуального оформления проекта студии IO Interactive на разных версиях графического API. Как стало известно , на канале Candyland в сервисе YouTube появилось как раз такое сравнение.

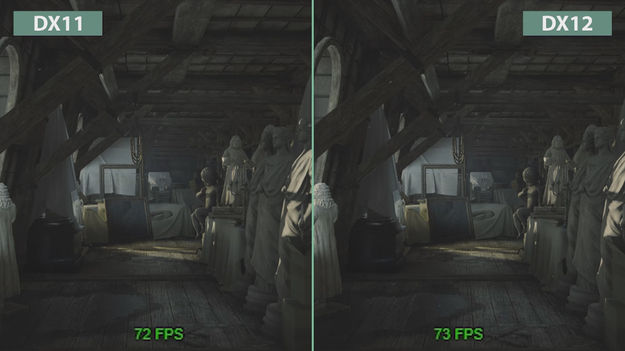

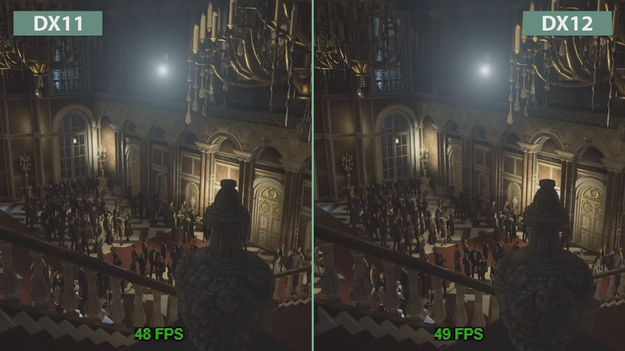

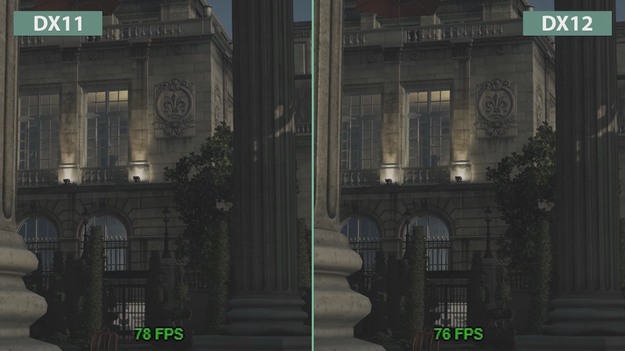

«В данном видео мы сравнивали производительность и визуальные эффекты игры Hitman при использовании DirectX 11 и DirectX 12 на РС на максимальных настройках. Для сравнения использовалась видеокарта Nvidia GeForce GTX 980. Обращаем внимание, что никакой ошибки тут нет. Похоже, что видеокарты Nvidia действительно не делают особой разницы между версиями DirectX, в то время как продукция AMD демонстрирует серьезное улучшение картинки», — говорится в описании ролика.

Различия в демонстрируемой картинке рассмотреть смогут только самые зоркие. Впрочем, в сети уже долгие месяцы ведется полемика о том, что архитектура видеокарт AMD прекрасно подходит для последней версии графического API от Microsoft, в отличие от Nvidia. Как бы то ни было, нужно отметить, что DirectX 12 скорее увеличивает эффективность работы видеокарты, а не влияет на качество графики игры в целом.

По данным , реализация поддержки нового графического интерфейса в Hitman для некоторых фанатов игры вышло боком. На странице игры в сети Steam участились жалобы от геймеров по поводу вылета игры при включенном DirectX 12. В дополнение, в некоторых случаях игра наотрез отказывается применять те или иные настройки графики, выбранные пользователем.

Hitman: Game of The Year Edition и еще 5 игр для ПК дают бесплатно и навсегда

Hitman: Game of The Year Edition и еще 5 игр для ПК дают бесплатно и навсегда

Полную версию Hitman предлагают взять бесплатно и навсегда

Полную версию Hitman предлагают взять бесплатно и навсегда

Hitman на ПК полная версия доступна бесплатно

Hitman на ПК полная версия доступна бесплатно

Hitman 3 раскрыли разработчики

Hitman 3 раскрыли разработчики

techspot.com/articles-info/1148/bench/Ultra_1600p.png

Tomb Raider,Gears of War remaster,Ashes of Singularity,Hitman уже используется DX12 и assync compute. ты слит!

Ну и где графическое превосходство в графике нового API, о котором вы так доказывали мне в прошлых новостях с пеной у рта? ГДЕ ОНО?

Ах да, как я мог забыть, вы же говорили о сверх повышенной производительности нового API по сравнению со старым! Ой, а где же оно? Вся разница в производительности уложилась в погрешность измерения частоты кадров.

Dx12 - чисто маркетинг и ничего больше. Ровном счетом вообще.

Нужен Dx12 для постановки Win10, как игровой платформы. То бишь берем Dx11, переименовываем в Dx12 и делаем его эксклюзивным для новой ОС. Теперь можно на нем и игрульки выпускать эксклюзивно, стадо захочет поиграть - пересядет на новую ОС.

МС так увлеклась пиаром, что забыла, что если продукт будет качественным, то никакой пиар просто будет не нужен. Но МС пошла другим путем - сделала говно, а теперь пытается выдать за конфету в красивой обертке.

Подождем еще, может завтра набегут.

Ты такой вопрос задавай ни геймерам, ни Microsodft (DX12), а задавай его NVidia.

Почему ей? Ну как минимум потому, что на ее карте тестировали.

Затем вспомни о тестах AMD на DX12. Там разница очень видна.

Ну и на последок, можно задать вопрос к IO Interective, почему в их игре так мало заметна разница между DX12 и DX11. Вполне возможно они решили схолтурить.

Ой ладно, наверно это и правда IO Interactive нахалтурили, посмотрим на другие тесты:

DirectX 11 vs DirectX 12 - Unreal Engine 4 Elemental Tech Demo: тут картина вообще смешная, DX11 выдает частоту кадров даже больше, чем DX12, а в некоторых новый API показывает свою мощь и догоняет DX11 и это кстати тесты что на амд, что на нвидия - тенденция не меняется.

Rise Of The Tomb Raider DX11 VS DX12 Performance: ситуация такая, что на DX11 выдает 85 фпс, на DX12 - 80.(Нвидия), про амд пишут мол фпс выросло в 2 раза, только никаких результатов реальных я не нашел.

Выходит странная ситуация. Все кричат о сверх производительности, а ее нет. Все кричат о графике, а ее нет. Видимо конторки, делающие UT4, и движок новой лары тоже схалтурили, как и IO Interactive.

Разница в FPS - проблема в разрабах и NVidia.

Про графон даже объяснять не буду. Тут и ежу понятно, что одно дело наличие инструментов, другое их реализация.

Про FPS. Есть наглядные синтетические тесты. Есть реальный тест игр.

В 3D Mark - API Overhead Test. Тесты 290х показывают, что AMD карты имеют огромный прирост в производительности при DX12 и Mantle. В отличии от DX11.

Игры - Ashes of Singularity. DX12 производительнее, чем DX11. И это притом, что игра в альфа-версии находится.

Вывод: многие разрабы сейчас будут пихать DX12 только по просьбе Microsoft (поддерживать переход на Win10) и только для галочки. Как следствие разницы мы не будем наблюдать, до тех пор, пока Майки не успокоятся, либо до тех пор, пока разрабы перестанут баклуши бить.

Что уж говорить о том, что д12 это д11.3, что как бэ намекает...

Д12 это для майков реально нечто новое.

"Одна игра - не показатель". Я бы так не говорил. Одно дело, когда игры делают на DX11 и с поддержкой DX12, другое дело, когда игру затачивают только под DX12.

Как итог, предлагаю сослаться реально на разрабов (в первую очередь). Потому, как хоть синтетика это всего лишь демонстрация, НО! Но она демонстрирует максимальные (как правило) возможности для того или иного испытуемого (в нашем случае DX12). А если синтетика показывает ошеломляющие результаты, а не погрешность в 0,01%, то и в реальных играх обязан быть такой результат.

P.s. Я считаю, что пока не начнут делать игры чисто на DX12, мы не увидим большой разницы между ним и DX11.

Для понятности приведу вот такой пример: На многих упаковках продуктов стоит маркировка "Без ГМО", "Не содержит ГМО". И это при том, что ГМО (как показали многочисленные исследования) не вредны для человека. Но маркетологи решили таким образом сыграть на незнании хомячков.

Так и тут. Кто-то проводил многочисленные иследования. Они принимались научным сообществом. Какие-то не принимались. Все просто.

дак мало того что различий в графике вобще-Вообще нет, так еще и хваленая производительность dx12 просто миф!

он же еще несколько фпс отхавывает

на данный момент dx11 это самый оптимальный выбор проверенный временем